KAYTUS, un fournisseur de premier plan de solutions d'IA et de refroidissement liquide de bout en bout, a annoncé aujourd'hui la sortie de la dernière version de sa plateforme MotusAI AI DevOps à l'occasion de l'ISC High Performance 2025. La plateforme MotusAI mise à jour offre des améliorations notables dans la performance de l'inférence des grands modèles et offre une large compatibilité avec de nombreux outils open-source couvrant le cycle de vie complet des grands modèles. Conçue pour une planification unifiée et dynamique des ressources, elle améliore considérablement l'utilisation des ressources et l'efficacité opérationnelle dans le développement et le déploiement de modèles d'IA à grande échelle. Cette dernière version de MotusAI est destinée à accélérer l'adoption de l'IA et à stimuler l'innovation commerciale dans des secteurs clés tels que l'éducation, la finance, l'énergie, l'automobile et la fabrication.

Ce communiqué de presse contient des éléments multimédias. Voir le communiqué complet ici : https://www.businesswire.com/news/home/20250612232564/fr/

Dans un contexte où les grands modèles d'IA sont de plus en plus intégrés dans les applications du monde réel, les entreprises les déploient à grande échelle pour générer une valeur tangible dans un large éventail de secteurs. Pourtant, de nombreuses organisations continuent de faire face à des défis critiques dans l'adoption de l'IA, notamment des cycles de déploiement constants, des exigences strictes en matière de stabilité, une gestion fragmentée des outils open-source et une faible utilisation des ressources de calcul. Pour résoudre ces problèmes, KAYTUS a lancé la dernière version de sa plateforme MotusAI AI DevOps, conçue pour rationaliser le déploiement de l'IA, améliorer la stabilité du système et optimiser l'efficacité des infrastructures de l'IA pour les opérations de modèles à grande échelle.

Amélioration de la performance de l'inférence pour garantir la qualité du service

Le déploiement de services d'inférence d'IA est une entreprise complexe qui implique le déploiement, la gestion et la surveillance continue des services. Ces tâches requièrent des normes strictes en matière de gouvernance des modèles et des services, d'optimisation des performances via des cadres d'accélération et de stabilité des services à long terme, ce qui exige généralement des investissements substantiels en termes de main-d'œuvre, de temps et d'expertise technique.

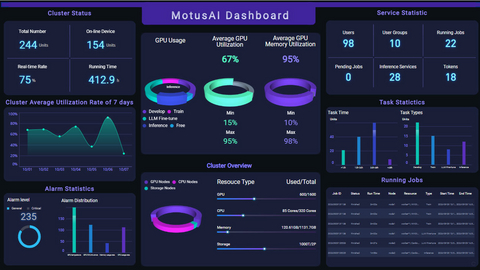

La version améliorée de MotusAI offre de solides capacités de déploiement de grands modèles, alignant parfaitement visibilité et performance. Grâce à l’intégration de cadres optimisés comme SGLang et vLLM, MotusAI garantit des services d’inférence distribués haute performance que les entreprises peuvent déployer rapidement et en toute confiance. Conçu pour prendre en charge des modèles à grand nombre de paramètres, MotusAI s’appuie sur une planification intelligente des ressources et de l’affinité réseau afin d’accélérer le délai de mise en service tout en maximisant l’utilisation du matériel. Ses capacités de surveillance intégrées couvrent l’ensemble de la pile – du matériel et des plateformes jusqu’aux pods et aux services – et permettent un diagnostic automatisé des défaillances ainsi qu’une reprise rapide des services. MotusAI prend également en charge la mise à l’échelle dynamique des charges d’inférence en fonction de l’utilisation en temps réel et de la surveillance des ressources, ce qui améliore la stabilité des services.

Des outils complets pour accélérer l'adoption de l'IA

Alors que les technologies des modèles d’IA évoluent rapidement, l’écosystème d’appui des outils de développement continue de croître en complexité. Les développeurs ont besoin d’une plateforme rationalisée et universelle pour sélectionner, déployer et exploiter efficacement ces outils.

La version améliorée de MotusAI offre un large soutien pour une vaste gamme d’outils open source de premier plan, permettant aux utilisateurs en entreprise de configurer et de gérer leurs environnements de développement de modèles à la demande. Grâce à des outils intégrés comme LabelStudio, MotusAI accélère l’annotation et la synchronisation des données dans diverses catégories, améliorant ainsi l’efficacité du traitement des données et raccourcissant les cycles de développement des modèles. MotusAI propose également une chaîne d’outils intégrée couvrant l’ensemble du cycle de vie des modèles d’IA. Celle-ci inclut LabelStudio et OpenRefine pour l'annotation et la gouvernance des données, LLaMA-Factory pour le perfectionnement des grands modèles, Dify et Confluence pour le développement d'applications de grands modèles, et Stable Diffusion pour la génération de texte à partir d'images. Ensemble, ces outils permettent aux utilisateurs d'adopter rapidement de grands modèles et de stimuler la productivité du développement à grande échelle.

Ordonnancement hybride de la formation et de l'inférence sur le même nœud pour maximiser l'efficacité des ressources

L'utilisation efficace des ressources informatiques reste une priorité essentielle pour les startups d'IA et les petites et moyennes entreprises qui en sont aux premiers stades de l'adoption de l'IA. Les clusters d'IA traditionnels allouent généralement des nœuds de calcul séparément pour les tâches d'apprentissage et d'inférence, ce qui limite la flexibilité et l'efficacité de la planification des ressources entre les deux types de charges de travail.

La version améliorée de MotusAI surmonte les limites traditionnelles en assurant la planification hybride des charges d’apprentissage et d’inférence sur un même nœud, assurant ainsi une intégration fluide et une orchestration dynamique de divers types de tâches. Doté de capacités avancées de planification GPU, MotusAI prend en charge l’allocation des ressources à la demande, offrant aux utilisateurs la possibilité de gérer efficacement les ressources GPU en fonction des besoins des charges de travail. Il intègre également une planification GPU multidimensionnelle, incluant le partitionnement fin et la prise en charge du Multi-Instance GPU (MIG), ce qui lui permet de répondre à une grande variété de cas d’usage allant du développement de modèles au débogage, en passant par l’inférence.

Le planificateur optimisé de MotusAI surpasse largement les versions communautaires, étant doté d’une amélioration de 5× du débit des tâches et une réduction de 5× de la latence pour les déploiements de POD à grande échelle. Il permet un démarrage rapide et une mise en disponibilité des environnements pour des centaines de POD, tout en prenant en charge l’adaptation dynamique des charges et la planification cyclique (tidal scheduling) pour l’apprentissage comme pour l’inférence. Ces capacités assurent une orchestration fluide des tâches dans un large éventail de scénarios d’IA du monde réel.

À propos de KAYTUS

KAYTUS est le chef de file des solutions d'IA et de refroidissement liquide de bout en bout. La société offre une gamme diversifiée de produits innovants, ouverts et respectueux de l'environnement pour le cloud, l'IA, l'edge computing et d'autres applications émergentes. Fort de son approche centrée client et de son business model adaptable, KAYTUS reste à la fois souple et réactif pour répondre aux besoins des utilisateurs. Pour en savoir plus, rendez-vous sur KAYTUS.com et suivez-nous sur LinkedIn et X.

Le texte du communiqué issu d’une traduction ne doit d’aucune manière être considéré comme officiel. La seule version du communiqué qui fasse foi est celle du communiqué dans sa langue d’origine. La traduction devra toujours être confrontée au texte source, qui fera jurisprudence.

Consultez la version source sur businesswire.com : https://www.businesswire.com/news/home/20250612232564/fr/

© Business Wire, Inc.

Disclaimer :

This press release is not a document produced by AFP. AFP shall not bear responsibility for its content. In case you have any questions about this press release, please refer to the contact person/entity mentioned in the text of the press release.