El Instituto de Innovación Tecnológica (TII, por sus siglas en inglés), pilar de investigación aplicada del Consejo de Investigación Tecnológica Avanzada (ATRC, por sus siglas en inglés) de Abu Dabi, anunció el lanzamiento de Falcon H1R 7B, un modelo de IA de última generación que supone un importante paso para hacer que la IA avanzada sea más accesible que nunca, al ofrecer un rendimiento de razonamiento de primera clase en un formato que es compacto, eficiente y de libre acceso.

Este comunicado de prensa trata sobre multimedia. Ver la noticia completa aquí: https://www.businesswire.com/news/home/20260105838080/es/

TII Launches Falcon Reasoning: Best 7B AI Model Globally, Also Outperforms Larger Models (Graphic: AETOSWire)

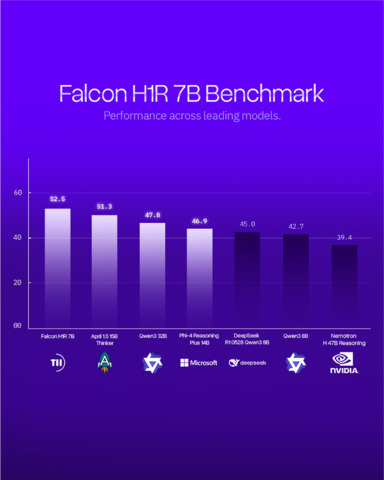

Con solo 7000 millones de parámetros, Falcon H1R 7B desafía y, en muchos casos, supera a los modelos de IA de código abierto más grandes de todo el mundo, incluidos los modelos de Microsoft (Phi 4 Reasoning Plus 14B), Alibaba (Qwen3 32B) y NVIDIA (Nemotron H 47B). El lanzamiento de este modelo reafirma la posición de TII a la vanguardia de la innovación eficiente en IA y refuerza la creciente influencia de los EAU en el liderazgo tecnológico a nivel mundial.

Su Excelencia Faisal al Bannai, asesor del presidente de los Emiratos Árabes Unidos y secretario general del Consejo de Investigación en Tecnología Avanzada, manifestó lo siguiente: "Falcon H1R refleja el compromiso de los Emiratos Árabes Unidos con el desarrollo de una IA abierta y responsable que aporte un valor real, tanto a nivel nacional como mundial. Al incorporar un razonamiento de primer nivel en un modelo compacto y eficiente, estamos ampliando el acceso a la IA avanzada de una forma que favorece el crecimiento económico, el liderazgo en investigación y la resiliencia tecnológica a largo plazo".

Un avance en el razonamiento durante las pruebas

Falcon H1R 7B se basa en los cimientos de Falcon H1-7B con un enfoque de entrenamiento especializado y una arquitectura híbrida Transformer-Mamba que mejora tanto la precisión como la velocidad.

"Falcon H1R 7B supone un gran avance en las capacidades de razonamiento de los sistemas de IA compactos", afirma la Dr Najwa Aaraj, directora ejecutiva de TII. “Alcanza puntuaciones casi perfectas en pruebas de referencia de élite, al mismo tiempo que mantiene un consumo de memoria y energía excepcionalmente bajo, criterios fundamentales para su implementación en el mundo real y su sostenibilidad".

Este enfoque desbloquea lo que los investigadores denominan "inteligencia latente", lo que permite a Falcon H1R 7B razonar de forma más eficaz y eficiente. El modelo establece una nueva frontera de Pareto, un punto óptimo de rendimiento en el que aumentar la velocidad no significa sacrificar la calidad.

Comparativa con los mejores

En pruebas comparativas competitivas, Falcon H1R 7B obtuvo resultados sobresalientes, como los que se mencionan a continuación:

- Matemáticas: obtuvo un 88,1 % en AIME-24 y superó a Apriel 1.5 (15B) de ServiceNow AI (86,2 %), lo que demuestra que un modelo compacto de 7B puede rivalizar o superar a sistemas que son mucho más grandes.

- Código y tareas agentivas: obtuvo una precisión del 68,6 %, el mejor rendimiento de su clase entre los modelos de menos de 8B, y obtuvo una puntuación más alta en LCB v6, SciCode Sub y TB Hard, con Falcon H1R obteniendo un 34 % en comparación con el DeepSeek R1-0528 Qwen 3 8B (26,9 %) de China, e incluso superando a competidores más grandes como Qwen3-32B (33,4 %).

- Razonamiento general: demostró una gran capacidad lógica y de seguimiento de instrucciones, al igualarse o acercarse al rendimiento de modelos más grandes como Phi 4 Reasoning Plus (14B) de Microsoft, aunque utilizando solo la mitad de los parámetros.

- Eficiencia: alcanzó hasta 1500 tokens/segundo/GPU en el lote 64, casi duplicando la velocidad del Qwen3-8B de China, gracias a su arquitectura híbrida Transformer-Mamba, que ofrece un rendimiento más rápido y escalable sin sacrificar la precisión.

“Este modelo es el resultado de una investigación y una ingeniería de primer nivel. Demuestra cómo la precisión científica y el diseño escalable pueden ir de la mano", afirma el Dr. Hakim Hacid, investigador jefe del Centro de Investigación Digital e Inteligencia Artificial de TII. "Estamos orgullosos de ofrecer un modelo que permite a la comunidad crear sistemas de IA más inteligentes, rápidos y accesibles".

Código abierto e impulsado por la comunidad

En línea con el compromiso de TII con la transparencia y la colaboración en materia de IA, Falcon H1R 7B se lanza como un modelo de código abierto bajo la licencia Falcon TII. Los desarrolladores, investigadores e instituciones de todo el mundo pueden acceder al modelo a través de Hugging Face, junto con un informe técnico completo que detalla las estrategias de formación y el rendimiento en los principales parámetros de referencia de razonamiento.

Esta nueva versión se basa en el éxito mundial del programa Falcon de TII. Desde su lanzamiento, los modelos Falcon se han clasificado de manera constante entre los sistemas de IA con mejor rendimiento del mundo, y las cuatro primeras generaciones han alcanzado el primer puesto en la clasificación mundial en sus respectivas categorías. A lo largo de sucesivas iteraciones, Falcon estableció nuevos puntos de referencia en cuanto a rendimiento, eficiencia y capacidad de implementación en el mundo real, al demostrar que los modelos compactos y soberanos pueden superar en rendimiento a sistemas que son significativamente más grandes. Estos hitos subrayan el creciente liderazgo de Abu Dabi y de los Emiratos Árabes Unidos en general en la vanguardia de la IA, así como la capacidad de TII para llevar a cabo investigaciones competitivas a nivel mundial.

*Fuente: AETOSWire

El texto original en el idioma fuente de este comunicado es la versión oficial autorizada. Las traducciones solo se suministran como adaptación y deben cotejarse con el texto en el idioma fuente, que es la única versión del texto que tendrá un efecto legal.

Vea la versión original en businesswire.com: https://www.businesswire.com/news/home/20260105838080/es/

© Business Wire, Inc.

Advertencia :

Este comunicado de prensa no es un documento producido por AFP. AFP no será responsable de su contenido. Para cualquier pregunta relacionada, por favor póngase en contacto con las personas/entidades mencionadas en el comunicado de prensa.